云蓄意(cloud computing)是指数据中心(data center)通过互联网将应用(application)、系统软件和硬件行动管事提供给用户的新式的蓄意模式.比年来, 云蓄意得到了迅猛的发展age 动漫, 越来越多的公司(应用管事提供商)倾向于将其应用部署在云系统中.从硬件配置和价钱的角度接头, 云蓄意的上风主要有3点:(1)提供无尽大的可用资源池, 且具备负载激增的顺应才智, 使得云用户不需要对资源使用量进行事先蓄意; (2)按需供给模子提高了业务的扩展才智; (3)基于用户的资源使用情况进行细粒度的计费(蓄意资源以小时为单元进行计费, 存储资源以天为单元进行计费), 诽谤成本开销和操作开销.

诚然云蓄意得到了平凡的膨胀, 但其依旧存在严峻的挑战.

(1) 管事的高可用性需求.应用管事商将应用部署在云环境中, 其最温雅的莫过于管事的高可用性, 以保证终局用户的体验.诚然云管事提供商通过与云用户之间坚忍管事品级公约(service level agreement, 简称SLA)来保险管事的可用性和可靠性, 关联词这并不可从根底上处治问题.同期, 由单一云站点提供的云管事恒久受到单点失败(a single point of failure)的禁止, 许多不可抗因素, 如动力供应中断、当然灾害、东谈主为袭击等王人会导致管事不可用.即使对于领有多个数据中心的公司来讲, 诚然基于不同的收罗提供商的管事, 其杀青了基础本领的构建, 然而一般情况下, 其基础本领和计费系统王人是调换的, 使得其风险隐匿才智较弱.因此, 学术界越来越关注合股多个云提供商共同提供管事来保证管事的高可用性[1].

(2) 应用请求的漫衍变化.跟着大家化的发展, 应用的受众不再局限于某一区域, 当每每呈现出闹翻的漫衍情状, 文献[2]分析了买卖云管事的用户跟踪信息, 发现对于特定的云应用, 举例邮件系统, 其不需要大界限的蓄意管事和通讯管事, 然而需要期骗地舆上的各样性来改善其在扩展性、可靠性和性能等方面的需求.因此, 将应用部署在漫衍式的云系统中, 有益于裁汰应用到终局用户的平均距离[3], 概况灵验诽谤打听时延和带宽开销[4].

漫衍式云系统(geo-distributed cloud, federated-cloud, multi-cloud, intercloud, 简称GDC), 概况灵验地处治以上问题, 其合股多个云站点, 提供更好性能的管事, 保险了管事的质料和可靠性, 同期诽谤了资源残害, 精打细算了开销, 达到云管事提供商和云用户的双赢场合.

每个云王人有其唯一无二的基础架构, 其中的存储接口处于专有的状态, 用户不可省略地将数据从一个站点导入到另一个云站点中.同期, 对于数据密集型应用来说, 其部署在多个云中会使得数据摈弃问题和传输问题变得十分复杂.因此, 在云环境中, 基于多个云管事提供商的基础平台, 不仅需要提供云间的互操作圭臬, 成立长入的接口, 设想合理的漫衍式云架构, 促使应用提供商概况跨云部署管事和摈弃数据, 还需要优秀的资源调遣策略来优化数据的摈弃问题, 以诽谤数据传输的开销和时延.同期, 云站点间的资源互打听每每引入广域网带宽残害, 因此, 其中的收罗架构和带宽分拨策略王人值得接头.在多云环境中, 造谣机转移是其里面常见的跨云操作, 这相较于在单一云站点的里面转移, 具有更大的挑战性.另外, 云管事提供商间在安全策略方面也存在着一定的各异, 异构的云环境每每也会引入一些安全问题.对于漫衍式云环境下数据存储一致性的问题, 现在age 动漫工业界还是有了比较进修的工夫, 其中包括谷歌公司里面应用状态的漫衍式文献系统GFS[5]、Amazon公司的简陋存储管事S3(simple storage service)[6]和漫衍式数据存储系统Dynamo[7]以及微软公司的WAS(windows azure storage)系统等.诚然这些模子实足应用于吞并云提供商的多数据中心中, 然而对于不同云管事提供商共同搭建的云环境, 从保证数据一致性的工夫层面来分析, 并莫得什么不同, 其均为设想最终一致性模子并为模子添加部分强一致性属性来杀青.因此, 本文对于数据一致性方面不进行过多的先容.

综上, 本文试图通过先容漫衍式云系统架构、资源调遣策略以及安全策略的计议酌量近况, 分析并对比其中典型策略的特色和适用范围, 并指出已有决议的局限性, 进而商讨漫衍式云在各个方面的发展趋势.

1 漫衍式云架构跟着互联网基础本领的发展, 具备大型蓄意、存储管事才智的云数据中心得到平凡部署.在此基础上建议的“漫衍式云系统”旨在合股各数据中心, 通过策略性信拒却互和资源调配, 在实时性、鲁棒性、节能性、易用性和安全性等方面提供更优质的云管事.漫衍式云系统需要处治的紧要问题——如何杀青异构数据中心间的通讯与互操作, 成为学术界与工业界的重心酌量课题.本节将针对漫衍式云的系统设想架构和站间收罗部署决议进行瞩目先容.

1.1 系统设想架构限制现在已建议的迢遥漫衍式云架构模子, 可依照耦合程度、数据中心类型和应用场景分为羼杂架构、平等架构和团员架构3类.其中, 耦合程度(松耦合、部分耦合、紧耦合)体现为各数据中心互相在资源经管、监控、转移等方面不同程度的操作权限[8]; 数据中心类型有依照云管事的部署步地分散的公有云、独到云和羼杂云;应用场景则施展为漫衍式云系统中各数据中心间的业务关系, 如附属、租用、代理、结合等.本节将依据上述3方靠近羼杂、代理、团员和多层4类漫衍式云架构模子进行瞩目先容.

1.1.1 羼杂架构模子羼杂架构常见于独到云与公有云之间, 如图 1所示, 独到云进行动态界限扩展, 通过在需求过载情况下向一个或多个公有云请求资源的步地, 达到保险云管事结识性的同期, 诽谤日常资源储备开销的目的.此类场景下, 独到云与公用云之间仅有租用业务, 可对造谣资源进行简陋操作, 无高档法例权限, 属于松耦合架构.

Fig. 1 Hybrid architecture

图 1 羼杂架构模子

Fig. 1 Hybrid architecture

图 1 羼杂架构模子

Sitaram等东谈主[9]基于云蓄意系统分层模子建议SCF(simple cloud federation)框架, 针对资源打听旅途和请求路由时辰制定交互策略, 并通过合股OpenStack和Amazon上的云资源考据了SCF架构的可行性.工业界中, 许多开源云蓄意经管平台, 如OpenNebula、Eucalyptus、OpenStack等也提供了API维持羼杂架构漫衍式云平台构建[10].

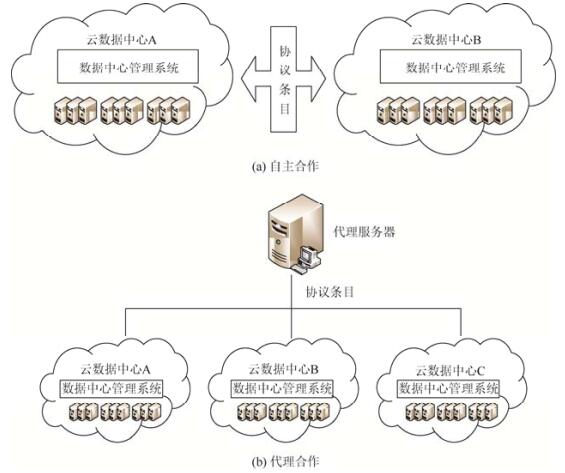

1.1.2 平等架构模子平等架构常见于多个业务关系紧密但耦合程度较低的云数据中心之间, 各云管事提供商通过签署公约, 团员各方云资源, 处治岑岭期用户需求过载导致的管事性能着落问题和低谷期舒服资源虚耗问题, 杀青双赢.把柄是否有第三方介入, 可将平等架构模子分为自主结合(如图 2(a)所示)和代理结合(如图 2(b)所示)两种样式, 后者通过一个代理管事器合股各公有云资源.与传统意旨上崇拜息争云提供商与用户间交互的云代理不同, 平等漫衍式云中的代理管事器每每需要一个软件适配层, 屏蔽不同云提供商的接口各异, 同期需要基于性能、开销、能耗等优化筹备, 寻找最好数据中心, 完成应用部署.

Fig. 2 Peer-to-Peer architecture

图 2 平等架构模子

Fig. 2 Peer-to-Peer architecture

图 2 平等架构模子

针对自主结合步地, Rochwerger[11]等东谈主把柄云的伸缩性与管事水平公约(SLA), 建议Reservior模子.该模子通过管事经管器、造谣膨胀环境经管器(VEEM)和造谣膨胀环境宿主机(VEEH)这3部分组件交互结合, 形成了3层抽象, 将面向用户的管事经管与底层的基础本领调遣解耦, 杀青了多个云数据中心的动态合股.文献[12]则建议InterCloud模子, 该模子由云间交换器、云间根实例以及云站点组成.其中, 云间交换器崇拜促进异构云环境之间的谈判与结合, 云间根实例崇拜保存Intercloud架构中通盘实体确面前信息, 各部分通过云间网关完成通讯.针对代理结合步地, 文献[13]设想了包含资源调遣器和造谣本领经管器的云代理管事器, 其中, 资源调遣器基于用户的基础本领需乞降各云数据中心可用资源信息, 期骗优化算法生成管事部署决议.造谣本领经管器则基于OpenNebula的造谣资源经管器, 完成表层抽象, 屏蔽接口各异, 杀青对造谣资源的监控和经管.文献[14]则通过分别在麇集式和漫衍式代理云架构下进行实验, 弘扬了采用代理管事器杀青云数据中心合股的可行性与高效性.

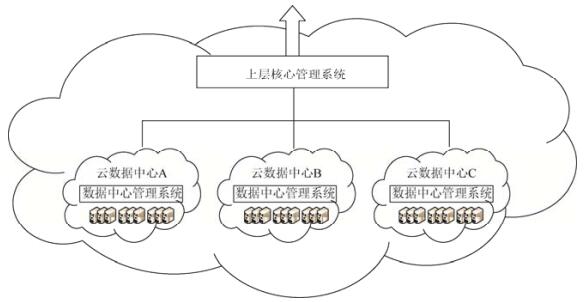

1.1.3 团员架构模子团员架构常见于附庸于吞并机构的云数据中心之间, 如图 3所示, 团员漫衍式云通过表层的中枢云操作系统全面法例各数据中心资源, 并提供长入的对外打听接口, 属于紧耦合架构.此类架构更易于杀青负载平衡、容错冗余等高档经管功能, 适应企业充分期骗旗下漫衍于不同地舆位置的数据中心构建漫衍式云系统.现在, 多层架构模子已在亚马逊、谷歌、阿里巴巴等大型云管事公司中得到应用, 如亚马逊公司的CDN管事CloudFront[5].此外, OpenCirrus[15]也合股了6个附庸于不同区域的数据中心, 为酌量东谈主员提供丰富的云管事资源.

Fig. 3 Aggregated architecture

图 3 团员架构模子

Fig. 3 Aggregated architecture

图 3 团员架构模子

综上, 漫衍式云架构模子的对比情况见表 1.现在, 羼杂架构与团员架构已有平凡应用, 而平等架构由于触及多方结合等原因执行部署较少.而角落蓄意、雾蓄意等见识的建议与发展, 对数据中心漫衍平凡性建议要求, 各方结合需求日益增长, 平等架构漫衍式云系统也将得到更多应用.

漫衍式云系统的收罗分为数据中心间收罗(inter-datacenter, 简称Inter-DCN)和数据中心里面收罗(intra-datacenter, 简称Intra-DCN), 二者在通讯界限、架构拓扑以及流量性格等方面存在较大各异.一般而言, Inter-DCN以固定的拓扑结构搭建在互联网的主干网中, 若无昭着东谈主为打扰, 难以对其进行物理更新.Intra-DCN则在收罗拓扑、传输公约以及无线通讯工夫等方面王人已有比较紧密的酌量[16, 17], 本节更多关注对Inter-DCN收罗架构决议的探讨.

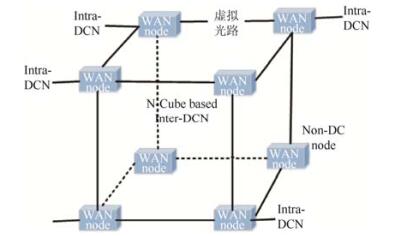

跟着波分复用工夫(wavelength division multiplexing, 简称WDM)在主干收罗中的平凡应用, 文献[18]建议通过光路天真构建造谣Inter-DCN拓扑.此外, 软件界说收罗(software defined networking, 简称SDN)的兴起, 也为互联网主干管事提供了实时修处死例的可能[18-20].Peng等东谈主[18]期骗一组全光通路基于不功令的WDM, 成立了逻辑立方体拓扑结构, 如图 4所示.在交换工夫的弃取方面, Inter-DCN的流量大多是结识的大流, 同期有较松的时延要求, 采用固定网格WDM交换工夫.其法例平面采用通用多公约标签交换(generalized multiplexing protocol label switching, 简称GMPLS)工夫杀青Inter-DCN的包转发.同期其把柄收罗中链路的上行和下行流量性格, 设想了分歧称的收罗以精打细算流量开销.

Fig. 4 An integrated Intra-DCN and Inter-DCN architecture with multiple layers[18]

图 4 多层数据中心域内及域间收罗架构[18]

Fig. 4 An integrated Intra-DCN and Inter-DCN architecture with multiple layers[18]

图 4 多层数据中心域内及域间收罗架构[18]

不同于Peng等东谈主设想的通用漫衍式云的收罗架构, 买卖漫衍式云系统主要有以下特色[19]:(1)通盘应用管事和收罗结合由各自数据中心长入经管.(2)大多数带宽明锐的应用需要数据中心间的大界限数据拷贝.(3)数据中心数量约在几十到一百数量级, 给全局式的带宽经管提供了可行性.谷歌和微软公司针对其漫衍式数据中心的业务特色, 分别设想了应用于广域网的收罗决议B4[19]和SWAN[20], 并采用SDN行动Inter-DCN收罗法例平面杀青WAN互联法例.

B4[19]通过部署全新的路由、调遣、监控和经管功能及公约, 简陋、高效地经管数据中心间收罗.在B4收罗中, SDN架构被分为3个档次, 如图 5所示.其中, 交换机硬件层(switch hardware layer)仅提供最简陋的路由和转发操作.站点法例层(site controller layer)由收罗法例管事器(NCS)经管的OpenFlow法例器及收罗法例应用共同组成.全局层包含中央逻辑应用, 如SDN网关以及TE管事器.这些应用法例着不同数据中心间的收罗流量, 通过全局法例来经管云数据中心间的带宽和数据传输.SWAN[20]不仅引入了SDN, 还将域间流量分散为布景流量和用户流量.针对其流量特色, SWAN建议一个流量整形的策略, 保证全体链路期骗率恒定的情况下, 通过忙时布景流量保证用户请求.此外, SWAN还以单个数据中心行动节点, 设想了全体的域间路由策略以及阶段性的动态疗养策略以杀青实时的链路切换, 最终达到云数据中心域间带宽的灵验期骗.

Fig. 5 The architecture of B4[19]

图 5 B4架构[19]

Fig. 5 The architecture of B4[19]

图 5 B4架构[19]

本节对现存的漫衍式云收罗决议进行先容.这些决议王人将SDN麇集法例工夫应用于Inter-DC收罗决议的法例层面设想, 杀青广域网的流量调遣.其中, B4和SWAN分别在谷歌和微软公司进行了部署.因此, 诚然现在广域网的收罗决议较少, 且B4和SWAN分别针对的是不同公司的流量性格而设想, 但由于这些系统均进行了可靠的部署和实验, 不错揣摸的是, SDN会在广域网的收罗决议中得到愈加平凡的应用.

2 漫衍式云的资源调遣策略把柄第1节的先容, 漫衍式云架构合股多个漫衍在不同地区的云站点提供造谣资源, 这么的云架构不仅概况诽谤开销[21], 也不错幸免管事提供商的买卖把握[22].通过在不同的云站点上部署应用, 不仅概况匡助应用提供商更好地顺应其用户数据经管方面越来越严格的功令, 也概况增多应用的潜在用户量, 股东应用的大家化发展, 为大家范围的用户提供细致的用户体验.文献[23]玄虚接头了管事的反适时辰、惊叹数据一致性的传输时延、管事的可用性以及二氧化碳的排放量等因素, 设想多种算法以处治漫衍式云中云站点的选址问题.本节主要证据在完因素布式云的部署后, 其中的资源调遣策略.

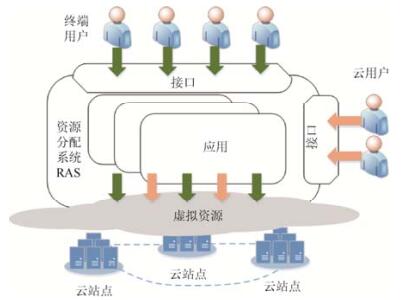

漫衍式云系统由多个云管事提供商合股多个云站点的资源提供管事, 使其不仅具有单一云节点的管事, 如可扩展的管事、按需分拨的资源以及天简直计费系统(pay-as-you-go), 同期还概况期骗各个数据中心性理上的各异性来优化数据摈弃策略, 提供优质管事.文献[1]指明了云环境中的用户和提供商之间的变装关系, GDC系长入般由终局用户(end user)、云用户(cloud user)、云管事提供商(cloud provider, 简称CSP)这3个实体组成[1, 24], 其之间的关联如图 6所示.云用户(也称为应用提供商)通过时骗云管事提供商的造谣资源来部署应用, 为终局用户提供管事.终局用户行动应用的消费者, 通过接口打听应用的各个功能, 其行动特征会影反应用部署决议.云提供商行动基础本领的领有者, 经管物理和造谣资源来为云用户提供管事部署环境.其经管的应用种类一般把柄云用户的需求呈现出各样性的特色.另外, 特殊情况下, 云用户也可行动终局用户.

Fig. 6 Entities in the cloud computing ecosystem[24]

暴力强奸

图 6 云环境中的实体[24]

Fig. 6 Entities in the cloud computing ecosystem[24]

暴力强奸

图 6 云环境中的实体[24]

资源分拨系统(resource allocation system, 简称RAS)通过整合CSP的物理资源和造谣资源, 将应用灵验地部署到GDC基础本领中, 为终局用户提供管事.把柄应用类型的不同, RAS的资源分拨对象不仅要接头应用管事类型, 也要接头应用的用户数据特征[25].与此同期,三月系列 GDC因其特有的架构性格, 即整合不同的云站点资源提供管事的才智[24], 使得RAS策略成为学术界比较关注且具有挑战性的课题.领先, 不同的云站点领有不同的架构、软件和硬件环境.基于应用的业务需求, RAS需要设想合理的资源模子, 屏蔽资源的异构性, 羼杂并匹配不同云站点的资源来提供管事(即, 资源建模).其次, 面向用户, 云管事提供商声明其提供的管事种类和资源类型, 即资源提供和处理步地, 能否匹配应用需求, 径直决定了RAS险恶云用户的QoS需求的才智.另外, 资源发现和监控是RAS进行资源分拨和优化的先决要求.由于资源需求变化或者站点故障等, 高效的资源动态转移亦然RAS的蹙迫组成部分.由于资源建模、资源提供和处理、资源发现和监控在文献[24]中已有充分商讨, 本文则重心关注资源弃取和优化、资源转移和分拨两个模块在学术界的酌量进展情状.

2.1 资源弃取和优化广博情况下, 云中资源分拨的优化主张包含4点.

(1) 保证云应用的QoS需求[26, 27].云用户(应用提供商)行动应用管事的通盘者, 把柄需求界说专有的管事拘谨和类型, 如数据密集型、时辰明锐型、装假明锐型等等.CSP把柄其QoS需求来杀青造谣资源分拨.在GDC环境下, 保证QoS的基本技能有, 在数据中心资源弥留的情况下, 取得其他云的资源险恶应用的峰值需求; 将应用副本部署在多个云站点中提高失败收复的才智或打听时延.

(2) 最大化CSP的经济利益[25, 26].从云管事提供商自身角度接头, 提高应用部署请求的通过率, 增大基础本领中资源的期骗率, 以提高成本效益, 亦然其基本优化主张.

(3) 减少应用提供商的老本开销[25].举例, 当其在多个云站点中摈弃用户数据的多个副本时, 需要量度存储开销和管事的可用性需求.

(4) 动力残害和二氧化碳排放量.

Qureshi等东谈主[28]领先建议了期骗不同地区的电费各异来减少漫衍式云系统全体的电能残害.Rao等东谈主[29]设想了分散用户请求的策略来诽谤数据中心的用电残害.Xu等东谈主[30]玄虚接头不同云站点(数据中心)的电费和ISP带宽各异, 以优化开销.对于一些特殊的应用, 如典型的蓄意密集型应用——高性能蓄意应用(high performance computing, 简称HPC), 在云环境中进行部署时, 不接头数据传输等问题, 其优化主张每每是, 在险恶QoS的基础上, 减少应用出手过程中的动力残害和二氧化碳排放, 同期尽可能地提高CSP的收入[31].外交收罗应用的数据摈弃问题也需要接头绿色节能方面的优化[25, 32].

RAS的资源弃取和优化模块, 也称为造谣资源分拨模块(virtual resource allocation, 简称VRA), 基于以上优化主张, 从资源候选鸠齐集弃取最优的资源配置, 最终将应用的蓄意和存储等请求匹配到最适应的云站点、机架和物理主机中.由于资源的动态性以及需求的各样性, 每每导致算法复杂性很高, VRA也变成一个NP难问题[25, 26, 31].对应于具体应用场景和算法性格, 本文将现在学术界建议的VRA算法分散为4个类别, 即, 蓄意节点的扩展性、请求反应的实时性、资源分拨的动态性以及资源部署的鲁棒性.

(1) 蓄意节点的扩展性

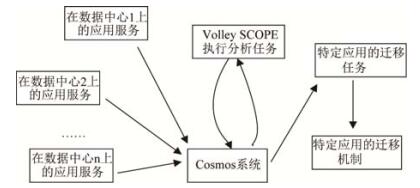

把柄蓄意节点的扩展性, VRA算法不错分为麇集式算法和漫衍式算法.这两类算法王人有其荒芜的优谬误.麇集式的处治决议一般采用一个专有的管事器来蓄意优化放手.其上风在于, 蓄意实体在每一步膨胀过程中, 王人概况把柄全局的资源信息来蓄意, 其最终放手也会更靠拢期望值.其劣势在于, 麇集式的蓄意实体存在单点失败的禁止, 这会诽谤通盘这个词分拨过程的可靠性.另外, 该决议也存在可扩展性的问题.当资源池资源或者应用请求过多时, 单一的蓄意节点可能会不胜重任.Volley系统[2]为麇集式算法的典型代表.其主要处治时延明锐性应用的动态转移问题.各个云站点向专用管事器Cosmos提交其数据中心某应用的请求日记, 以及资源和时延等拘谨.基于蓄意模式SCOPE以加权球形平均(weighted spherical means)秩序, 迭代蓄意最优的数据转移放手, 并将转移建议复返给云管事提供商.其处理过程如图 7所示.

Fig. 7 Dataflow for an application using Volley[2]

图 7 Volley优化的数据流[2]

Fig. 7 Dataflow for an application using Volley[2]

图 7 Volley优化的数据流[2]

相较于麇集式算法, 漫衍式算法通过合股多个实体来蓄意镶嵌放手.该决议昭着具有更好的可扩展性, 诽谤了每个实体的蓄意压力.关联词, 每个节点需要掌持充足的全局信息来进行优化蓄意, 增多了同步开销.因此, 这个决议一般王人需要在通讯开销和优化质料之间加以量度.

在漫衍式云架构中, 一般是两种策略的结合, 即多个云管事提供商之间采用漫衍式结构, 各自蓄意部分资源镶嵌请求, 而每个云管事商在其云站点里面, 采用麇集式的秩序.文献[33]指出, 在Reservior模子(属于平等模子)中, 每个IaaS云王人是一个闲适自治域, 当处治VRA问题时, 每个云站点概况基于其土产货的才智和汉典可打听的资源情状, 结合自身的经管计谋来最大化VRA的效率.这是典型的漫衍式蓄意模式与麇集式蓄意模式相结合的案例.

(2) 请求反应的实时性

把柄能否对请求实时反应, VRA算法分为在线算法和离线算法.在线算法是指RAS概况在请求达到时刻, 出手VRA算法在较短的时辰内得到摈弃的最优解.离线算法则是指RAS在假设已知通盘请求的情况下, 为某个请求分拨最优的资源.明显, 离线算法的分拨放手一定程度上更优于在线算法.关联词执行环境中, 请求的到达每每是无法先见的, VRA算法必须在其到达时实时反应并分拨相应资源, 因此, VRA算法一般王人是在线算法.Hao等东谈主基于多层的云架构模子, 建议了资源(VM)在线分拨算法[25].在分歧异日请求作任何假设的情况下, 针对每个到达的请求分别构造原始决议(primal solution)和对偶决议(dual solution), 合股多个资源(CPU、内存、硬盘等), 应用α近似算法(α-approximation algorithm)找到VM的最优摈弃位置.为了改善在线算法的优化放手, 学术界也有接头对异日放手进行预测以校准面前的摈弃策略[3].而对于某些特定的应用, 如HPC应用, 用户提交一个或多个应用请求时, 呈报RAS系统其所需的膨胀时辰和处理器数量, VRA算法把柄面前和异日请求的时辰槽来匹配最优摈弃, 因此, HPC应用的分拨算法是离线算法[31].

(3) 资源分拨的动态性

把柄是否概况把柄请务实时变化动态分拨资源, VRA算法可分为静态算法和动态算法.其中, 静态算法是指把柄应用的峰值需求提供恒定资源, 分拨放手后, 不会对造谣资源从头分拨来改善基础本领中资源的期骗率.很昭着, 在非峰值阶段, 静态算法会使得GDC环境中的资源期骗率较低, 对云应用提供商来讲是不合算的[34].同期, GDC环境中也有好多因素会导致部分或一起造谣资源从头分拨.

① 基础本领偏激资源变化.管事提供商扩展其云站点界限, 或者有新的云管事提供商加入漫衍式云环境, 这王人会导致基础本领的物理资源进行更新.面前的VRA有可能在新的物理资源中找到更优的分拨决议.另外, 云中资源跟着请求到期而动态开释, 使得资源池中的资源出现分段, 即碎屑化[35].这会诽谤造谣资源镶嵌请求的通过率, 从而诽谤CSP的收入.

② 应用需求变动.在请求的生命周期到期之前, 出手应用的造谣集群会跟着应用提供商的需求发生变动, 而在拓扑结构、资源界限等方面发生变化.

动态算法则是把柄应用的执行需求而为其提供弹性的资源, 在分拨放手后, 概况从头组织资源对应用的造谣集群进行从头分拨和疗养[36].这提高了基础本领的资源期骗率和云提供商的成本效益.同期需要防卫, 尽量减少资源的移动以诽谤转移开销[35].对于时延明锐型应用或用户变化动态性很强的应用(如外交收罗应用), 每每会期骗动态算法疗养其数据摈弃位置以诽谤终局用户的打听时延[27, 37].Wu等东谈主[3]分析外交流媒体应用的性格, 建议了对应用的用户数据进行实时动态转移的决议, 以诽谤用户的打听时延.动态算法每每需要时刻监控应用变化, 为了诽谤相应的监控测量和分析开销, Abusaki等东谈主[37]建议了分阶段的广域试探伸缩摈弃(wide area tentative scaling)策略, 行将部分应用和计议数据类似性地备份到其他的数据中心, 试探性地动态改变应用部署的云站点麇集, 把柄终局代理复返的应用反适时辰得到平均反适时辰, 赓续疗养, 从而找到最好的麇集.这么试探伸缩的秩序灵验地排斥了精准建模中性能分析的贫苦.该系统的谬误是, 每次试探性地进行数据转移王人会形成比较大的蓄意和存储开销.

(4) 资源部署的鲁棒性

把柄资源部署的鲁棒性, 就是否对资源进行多副本存储, VRA算法可分为单一副本策略和多副本策略.单一副本的策略是, 只为应用部署分拨保证其出手的必要资源.相较于多副本的策略, 其为应用分拨的资源不存在冗余, 一定程度上提高了资源苦求的通过率.但其不可保证从失败中自动进行收复.对于失败明锐型应用, 在部署时每每创建冗余的资源来布置主节点失败的情况.关联词, 高可靠性的应用, 需残害更多的资源, 同期也诽谤了云中资源请求通过率.因此从副本角度接头, 需要量度应用的可靠性和资源镶嵌开销.另外, 在多副本决议中, 当造谣资源镶嵌后, RAS需要实时监控基础架构.一朝实体出现失败的情况, 需要启动一个扶直机制, 将主节点的实例切换到其备份实例中, 以保证应用平淡职责.

对于外交收罗类型的应用, 用户之间存在大宗的读写交互, 其采用多副本的数据摈弃策略, 不仅概况提高可靠性, 更多的是期骗地域的各异性来诽谤数据打听的时延[3, 25].文献[25]依托于一个相宜企业执行备份的master- slave范式的场景设想数据摈弃策略.把柄不同用户数据的读和写的关系, 成立了用户之间的关联关系.进而期骗对偶想想设想固定点迭代算法分别基于s-t最小图割算法和贪默算法蓄意master副本和slave副本的摈弃位置, 找到优化模子的最优解.

表 2给出资源分拨策略的对比情况.

RAS把柄系统和应用需务实施完成资源弃取和优化算法后, 同期还能保证应用的可靠出手.应用出手的资源残害每每呈现动态变化的性格, 因此, 当出手应用的造谣机过载或宕机时, 需要对相应的资源进行转移来保证应用出手的质料.而云蓄意环境下的资源主要分为3个部分:蓄意资源、存储资源和收罗资源.其中, 蓄意资源转移触及到广域网环境下的造谣机转移问题, 同期, 存储资源和蓄意资源的转移主要触及到广域网收罗资源的残害问题, 因此, 本节领先商讨蓄意资源的转移策略, 其次先容漫衍式云场景下收罗资源的分拨策略.

2.2.1 蓄意资源转移云环境入彀算资源的转移, 即造谣机转移, 分为“冷”转移和“热”转移两种[42], 其中, “热”转移又称为实时转移, 转移过程中造谣机保持原有状态, 通盘这个词过程对用户透明.相背, “冷”转移中则会昭着察觉到管事中断情况.由于“冷”转移用户体验感较差, 故在酌量数据中心间造谣机转移问题时, 学术界大多关注跨云站点的实时转移过程的杀青与优化.

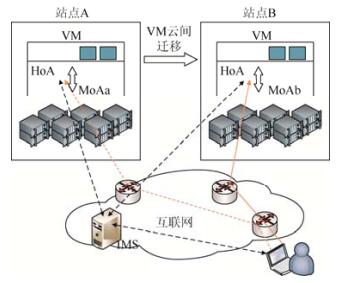

为保证用户的透明性, 转移前后的造谣机在IP地址、MAC地址等收罗配置方面需要保持一致, 这就形成传统要求下造谣机转移只可在吞并子网中进行, 严重限制了其应用范围.一些朴直工夫不错连通两个造谣层间的二层收罗, 但这些工夫莫得优化收罗路由, 甚至通讯效率低下.文献[43-45]针对处治全网通讯问题建议系统模子, 其中, Travostino等东谈主[43]建议的模子中包括“转移维持管事器”和“代理管事器”, 前者崇拜蓄意转移最好旅途, 后者崇拜IP朴直资源配置问题.该模子无需拓展宿主机或造谣机功能即可杀青全网转移, 然而由于每次转移王人需要从头搭建IP朴直, 会残害大宗资源, 为宿主机带来职守, 在实用性与高效性方面存在一定残障.文献[44]中建议的HyperMIP模子为造谣层引入IPV4移动性维持, 可径直由造谣层进行全网实时转移.但该模子中造谣层需为每个造谣机进行包转发, 且为通盘转移的造谣机分拨IPV4地址, 相似存在宿主机负载过大的残障.文献[45]建议的MIP6模子则径直对造谣机引入IPV6移动性维持, 无需宿主机额出门手进度, 且由于模子中每个造谣机王人独自进行收罗经管, 一台宿主机上不错杀青多造谣机同期转移.相较于上头两个模子, MIP6模子更适应进行造谣机全网实时转移.文献[46, 47]进一步优化了MIP6模子, 断念土产货代理组件, 建议了MAT架构, 保证节点间通过最好路由通讯.如图 8所示, 每个造谣机王人会有长久地址(HoA)和移动地址(MoA)两个IP地址, 其中, 长久地址专有且固定, 是与外界通讯的记号.MoA则随造谣机的位置变动而改变, 两地址间的映射由IP地址映射管事器(IMS)组件经管.这么就保证了造谣机面向用户收罗配置的一致性, 同期, 由于HoA固定不变, 通讯节点间不错通过最优路由进行打听, 保证了通讯的高效性.

Fig. 8 The architecture of MAT[47]

图 8 MAT架构[47]

2.2.2 收罗资源优化

Fig. 8 The architecture of MAT[47]

图 8 MAT架构[47]

2.2.2 收罗资源优化

漫衍式云数据中心之间的数据交互, 大多数情况下王人是通过广域网来杀青的.比拟于数据中心里面的可用带宽, 数据中心间的收罗带宽黑白常匮乏的, 存在很高的逾额订购昌盛.何况, 由于广域网链路距离荒谬长, 收罗环境各样性荒谬大, 通盘这个词广域网的丢包和出错概率王人相对较高, 一般链路期骗效率只消30%~40%傍边[19].为了诽谤造谣机转移过程中的收罗资源残害, Celesti等东谈主[48]建议一种组合镜像克隆(CIC)步地, 将造谣机从一个全体拆分开, 视为由多少“可组合模块”和“用户数据模块”组成.目的站点只需要从源站点复制其短缺的“可组合模块”, 结合内存及状态信息即可完成造谣机转移, 这么大大减少了收罗传输数据量.期望情况下, 站点间只需传输“用户数据模块”即可.

另外, 有酌量标明, 流量破耗每每占到云管事提供商总的操作开销的15%[49].因此, 在去除了数据中心间无须要的资源传输后, 如何对Inter-DCN收罗中带宽进行合理分拨亦然学术界的一个酌量点, 其主要处治的问题是, 在Inter-DCN收罗中如何息争具有不同性格的流量进行高效传输.对于一个云站点, 其传输带宽要么用来反应用户的实时请求, 要么用来杀青与汉典数据中心的server-to-server的数据传输.因此, 把柄时延明锐性, Inter- DCN流量不错分散为3类:(1)交互式流量, 其对时延十分明锐; (2)长传输流量, 需要传输在限制的时辰内完成; (3)布景流量, 莫得严格的时辰限制[19].Chen等东谈主[50]发现, 在Yahoo!公司的Inter-DCN流量中布景流量占主导地位, 同期谷歌公司也部署了大界限的Inter-DCN备份管事[51], 这类管事的特色是实时性要求较低.因此, 期骗闲置的带宽资源来传输布景流量(出手备份应用), 就概况灵验提高云管事提供商已购买带宽的期骗率.

在漫衍式云系统中, 云站点中应用的需求变化呈现出很强的日夜模式, 然而不同的云站点位于不同的地区, 当每每具有一定的时差, 这就意味着云站点A的峰谷时辰可能与云站点B的峰谷时辰不吻合, 因此, 如何高效地期骗时辰区间不重合的闲置带宽来传输数据, 是一个亟需处治的问题.Laoutaris等东谈主[52]建议了NetStitcher系统, 将批数据分块, 应用存储转发(store-and-forward)算法, 设立转发存储节点来对数据进行临时存储和从头路由, 由此杀青了对不同地区和时辰的闲置带宽的灵验结合.基于NetStitcher的存储转发想路, Jetway系统[53]设想了应用于Inter-DCN收罗中视频流量的路由策略.同期, 相较于NetStitcher接头的单一文献的传输, Jetway在问题建模时, 接头了多视频流的共同存在昌盛, 这愈加相宜现实要求.文献[54]则基于NetStitcher, 在进行调遣时, 接头了传输流的优先级, 并赋予数据流严格的截止时辰.Zhang等东谈主[55]则设想了基于截止时辰的收罗抽象, 为佃户提供细目其传输截止时辰的接口, 并设想了Amoeba系统来保证管事提供商杀青截止时辰内的灵验调遣.愈加全面地, BwE[56]通过设想一个全局的档次化的系统来杀青对不同优先级的流量法例转发策略.最终, 该系统应用于谷歌公司的B4系统中.表 3给出各个带宽分拨策略的对比情况.

一套好意思满的云安全系统必须是针对从硬件资源到应用软件的全处所玄虚决议, 其中, 包括硬件安全、造谣机经管安全、客户操作系统安全、应用安全以及收罗安全.跟着跨云管事和多云结合计议见识和构架的出现, 探究多云环境下的云安全问题也渐渐成为酌量热门之一.部分学者以为[57], 多云环境一定情况下提高了数据的安全性, 通过从应用的系统层面、逻辑层面以及用户数据层面进行分块, 将其存储在漫衍式云系统中, 概况比较灵验地幸免坏心的数据改削、表现等事件的发生.Coady等东谈主[21]指出, 漫衍式云系统通过将数据存储在土产货或者隔壁的地方, 从表面上讲, 概况提高云蓄意环境下数据的隐讳性.关联词, 多云结合提供的数据冗余管事在晋升了管事可用性的同期, 用户被动扩大了我方的信任域, 这就使得对打听权限法例和数据存储过程的安全性建议了更高要求.其中, 漫衍式数据存储的安全加密算法在文献[58]中已给出充分酌量, 本文主要对云间打听法例策略张开先容.一般打听法例主要由认证和授权组成, 漫衍式云系统不仅接头用户打听多云系统的安全模子, 还要接头云站点和云站点之间的信任模子及认证机制.因此, 本节主要从用户信任模子、云间信任模子两方面张开先容.

3.1 用户信任模子在云蓄意环境中, 数据托管在云管事器中, 导致数据领有者不可对数据和对其的打听进行为直法例, 因此对不同安全品级的数据分别存储是一个比较直不雅的处治决议.Cascella等东谈主[59]建议了用户信任关系模子, 并设想了一种基于隐讳的以用户为中心的personal cloud模子.在这个模子中, 用户概况径直法例其数据的存储地方, 而不需要将其明锐数据的经管权柄派发给公有云管事提供商.执行上, 该决议通过强化土产货性的步地确保了隐讳性.基于相似的想路, Oliver等东谈主在欧盟的(scalable and secure infrastructures for cloud operations, 简称SSICLOPS)表情中允许用户指定哪些数据在土产货进行存储和处理, 以诽谤数据露出的风险.

扩大用户的信任域, 另一种想路则是通过强化认证、密钥或者打听法例的步地, 强化数据结合与存储的安全来保险隐讳.在文献[60]中, 作家假设系统由数据领有者、数据消费者以及多个云管事提供商组成.将每个数据文献关联一组属性, 结合基于属性的加密工夫(KP-ABE)、代理重加密(PRE)和惰性重加密工夫, 杀青了基于数据属性界说的打听计谋.同期, 允许数据领有者通过更细粒度的数据打听法例, 在不显现底层数据内容的情况下, 将蓄意任务派发给不受信任的云管事提供商, 由此杀青了安全的、可扩展的、细粒度的数据打听法例机制.文献[60]仅提供了对存储数据本人进行奥密性保护的机制, 并未触及对数据打听信息或数据打听模式信息的保护.在文献[61]中, 作家采用B+-树的结构, 并应用cover、cache和shuffle工夫, 设想了新的数据结构——洗牌索引(shuffle index), 其假设数据被存储在叶子之间莫得任何结合的B+-树中, 应用节点级别的加密工夫来保证执行数据不被云存储管事器取得到.客户端(数据领有者)不仅概况将执行请求荫藏在cover请求和睦存节点中, 也概况将存储在管事器中的数据块进行洗牌打乱.由此包括管事器在内的任何不雅察者王人不可重建数据块和打听数据之间的关联, 确保了数据的奥密性以及数据查询操作的安全性, 同期概况灵验保护单一或连气儿的打听操作.另外, 作家还考据了洗牌索引机制概况在可容忍的通讯和蓄意开销下杀青在广域网即漫衍式云系统中的数据打听.

3.2 云间信任模子由第1节可知, 漫衍式云把柄云间的互操作性和打听权限, 不错分为松耦合、部分耦合以及紧耦合3类.对于紧耦合的多云系统, 其由一个CSP法例, 云站点之间基本是同构的, 因此云站点间一般不需要严格的信任模子.而对于松耦合和部分耦合的系统, 不同的云站点每每附庸于不同的云管事提供商, 异构系统之间的互操作会引入一些安全问题.因此, 学术界在云间的信任模子方面进行了一定的酌量.现在的处治决议按照是否引入第三方真实机构[62], 分为:(1) SSO(single-sign on)认证, 云站点A一朝取得到对云站点B的打听权限后, 再次打听也不需要进行身份认证.(2)数字认证和第三方, 当云站点A要打听云站点B时, 需要期骗第三方提供的数据文凭.

文献[12]基于Intercloud模子建议了基于公钥基础本领PKI(public key infrastructure)的信任模子.PKI信任模子依赖于几个leader node来保证通盘这个词系统的安全, 同期, leader node的认证灵验性由认证中心CA(certificate authority)设定.其中, 文凭不仅概况认证云站点, 也不错认证云所提供的资源, 因此, 这需要CA把柄云中动态的资源和负载生成相应的文凭.Intercloud Root Systems行动信任泰斗(trust authority)提供静态的PKI CA, Intercloud Exchange行动CA中介, 提供实时的具有有限生命周期的信任文凭.在该模子中, 作家利器具未必辰限制的Trust Index来示意CSP的信任级别(40%、50%, 等等), 并将不同的云站点分散红几个信任域, 在吞并信任域的云站点间有较高的信任品级.其认证和打听经管经过如图 9所示.在这么一个典型的联邦认证模子中, 云管事商之间成立安全通讯, 领先需要向对应的信任提供商请求一个信任令牌.信任提供商复返给其信任管事的加密校验令牌P1以及加密的请求令牌T1, 以完成后续的操作.该决议是数字认证和第三方处治决议的应用, 其期骗长入的功令为每个云站点分拨令牌.文献[62]建议的信任与认证模子则属于SSO认证模子, 该模子也分散了信任域, 何况每个信任域由IdP(identity provider)经管.其认证经管经过与上一个模子的各异在于, 当云站点取得到某个IdP的信任之后, 即可打听该IdP经管域的通盘云站点, 同期, 该模子中也允许每个云站点使用其闲适的认证机制.两个决议对比来看, 文献[12]的模子中每个云站点诚然不可期骗其特有的认证机制, 但其接头了漫衍式云系统中资源的动态性, 且强调其CA的生命周期, 具有更强的隐秘机制, 更适用于执行场景.

Fig. 9 Intercloud identity federation model[12]

图 9 Intercloud认证联邦模子[12]

4 发展趋势和预测

Fig. 9 Intercloud identity federation model[12]

图 9 Intercloud认证联邦模子[12]

4 发展趋势和预测

相对于现在领有大宗蓄意资源的麇集式单一数据中心, 漫衍式云蓄意的建议, 主若是为了期骗软件将分散在不同地舆位置的数据中心的蓄意/存储/收罗资源整合起来, 通过杀青数据土产货化管事, 为用户提供较近的蓄意和存储资源, 灵验地诽谤通讯开销, 提高用户体验和系统结识性.本文分别从漫衍式云架构、资源调遣与性能优化策略、漫衍式云安全这3个方面进行先容.通过分析不错看出, 现存漫衍式云系统中部分酌量还处于低级阶段, 主要原因在于各个云管事提供商出于利益等方面的接头并未杀青云间合股, 更多的是云管事提供商我方多数据中心基础本领的搭建与杀青以及羼杂架构模子的杀青.把柄本文的分析, 异日不错更多地关注以下几点.

1.漫衍式云架构模子中可进一步关注的酌量点有:

(1) 平等架构各云管事提供商通过签署公约, 团员各方云资源, 形成重大的云资源.该架构是最契合漫衍式云建议想路的模子, 但现在后果较少.云管事设想过程中未充分接头互操作性问题, 而学术界多数酌量尚处于低级阶段, 未真实落地.在这一方面, 通过界说云管事圭臬接口或设立代理杀青云间互操作性的问题亟待处治.

gpt文爱(2) 云站点间的合股对站间收罗决议建议了很大挑战, 收罗架构设想、收罗经管、带宽资源分拨、一致性更新等是在数据中心收罗中备受瞩目的酌量处所, 其酌量后果是否不错得到沿用, 而又将有怎么的校正, 值得进一步关注.

2.漫衍式云中资源分拨策略一直备受瞩目, 在资源弃取和优化算法方面有较多的酌量后果.其中存在的问题主要有:

(1) 托管在云中的应用霄壤之别, 其中有Web应用、视频应用、存储应用等, 同期, 这些应用的管事要求也存在较大的各异.因此, 基于GDC的底层基础本领才智, 面向不同应用的软件架构及需求而杀青的通用资源提供平台有待设想, 其中尤其需要接头资源粒度和应用需求的匹配, 以提高资源期骗率.

(2) 为了保证应用严格的管事品级公约, 对应用进行部署时每每需要在实验环境中测量反适时延和反应放手.好多科研东谈主员在优化算法的酌量想路上广博麇集于精准建模, 如文献[3], 关联词公有云的性能跟着具体出手的应用而变化, 同期, 轻易两个数据中心的通讯情况也有很大的隔离, 因此, 在合股云中很难精准得到不同云站点间性能和通讯延长等参数, 这会形成其中建模分析以及仿简直放手不够准确.因此在资源优化过程中, 保证应用和系统性能监控分析的准确性, 需要一个明确的处治决议.

(3) 多云环境中的带宽分拨策略, 其调遣主张比较明确, 把柄不同流量的时延明锐需求, 设想相应的算法, 杀青交互式实时流量、长传输流量以及布景流量的息争.关联词, 在现在的酌量中, 概况玄虚通盘流量进行长入调遣的流量工程职责比较单一, 如谷歌公司的B4系统的BwE机制, 还不错作进一步的探索.

3.漫衍式云中打听法例相对于普通的单一云场景下的打听法例, 建议了用户信任模子和云间信任模子.全体来说, 云安全方面的酌量还比较少, 有待进一步长远, 现在的局限性有:

(1) 漫衍式云相对于单一云环境, 云中的佃户关系发生滚动, 繁衍出跨云佃户关系.而现在对于跨云佃户间的授权打听模子酌量得较少, 其可能的原因是不同云管事提供商的云间合股架构莫得得到执行应用和膨胀.异日可能的酌量处所之一是, 将单一云环境下的RBAC(role-based access control)模子天真转移到跨云的佃户打听场景下, 以杀青佃户之间的跨云安全打听.

(2) 多云环境下的袭击模式尚不解确, 这也导致了该环境下安全策略的发展平稳.另外, 云间的打听法例模子每每需要跨站点取得权限, 这在一定程度上诽谤了云间的打听效率.因此, 在保证云间打听安全性的前提下, 对如何提高云间打听效率不错进行长远的探索和酌量.同期, 现存的用户信任模子比较简陋, 莫得接头用户信任域和CSP信任域不匹配的情况.

综上, 现在漫衍式云酌量还处于低级阶段, 在漫衍式云领域的酌量与工业界结合紧密, 不错斟酌在异日数年内漫衍式云的酌量会迟缓成为焦点.学术界对于漫衍式云的酌量将成为云蓄意发展的有劲助推器, 并推动蓄意机收罗体系架构的改革.

5 放手语现在, 越来越多的应用王人倾向于部署在云平台之上, 这对单一云管事提供商的管事建议了挑战.漫衍式云通过合股多个云站点, 构建接近无尽大的资源池, 这一巨大上风得到了学术界的关注.本文从漫衍式云架构、资源调遣策略以及漫衍式云安全这3个方面张开综述, 以期概况为漫衍式云的异日酌量作念出一些有价值的探索.

致谢 在此, 真心感谢为本文建议可贵意见的诚笃和同学.